Vous aimez tester des illusions ? Nous vous invitons à expérimenter un phénomène illusoire lié à la perception de la parole !

Pour débuter l’expérience, cliquez sur la vidéo.

Le phénomène « McGurk » a été décrit pour la première fois en 1976 (McGurk & MacDonald, 1976) et reproduit par de nombreuses équipes de recherche partout à travers le monde, avec des locuteurs de différentes langues. Depuis, de nombreuses équipes de recherche ont tenté de comprendre le fonctionnement de l’intégration audiovisuelle, au cours de cet effet : à quel moment se produit-elle ? Est-elle obligatoire ? Change-t-elle avec l’âge ? Quelles régions du cerveau sont impliquées ?

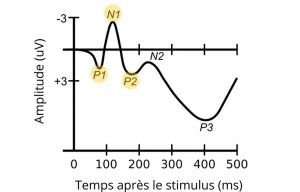

De nombreuses équipes de recherche ont étudié le phénomène d’intégration audiovisuelle avec l’électroencéphalographie (EEG), une technique qui permet de mesurer l’activité électrique du cerveau à l’aide d’électrodes placées sur le cuir chevelu. L’EEG permet de mesurer des potentiels évoqués, soit des réponses du système nerveux central à une stimulation (p. ex. à un son entendu). Les potentiels évoqués peuvent être observés sur un tracé (Luck, 2014). Certains d’entre eux ont été associés à l’intégration audiovisuelle, tels les potentiels formant le complexe P1-N1-P2 (voir figure 1). Ce complexe se compose de déflexions positives et négatives culminant à environ 50 ms (P1), 100 ms (N1) et 200 ms (P2) après le début du stimulus, tel un son. Cette série de potentiels évoqués auditifs indique qu’un son a atteint le cortex auditif et que le traitement acoustique-phonétique a été initié dans le cortex cérébral, c’est-à-dire que le traitement des caractéristiques du son telles la hauteur (±aigu) ou la durée (±long), qui permettent de distinguer les sons de la parole (p. ex. le son /p/ vs. le son /ch/), a été amorcé. Il est possible de caractériser les potentiels évoqués en fonction de la latence (durée entre l’apparition du stimulus et du « pic » du potentiel évoqué, mesurée en millisecondes) et de l’amplitude (« largeur » du potentiel évoqué, mesurée en microvolts ou µV – un microvolt représente un millionième de volt, il s’agit d’activité électrique très faible !).

Figure 1. Schéma illustrant le complexe P1-N1-P2 (Components of ERP), adapté de Choms, sous licence CC BY-SA 3.0.

Il est bien établi que, en comparaison à la perception auditive seule, l’ajout d’informations articulatoires visuelles diminue l’amplitude et la latence du complexe N1/P2 (p. ex. Besle et coll., 2004; Klucharev et coll., 2003 ; Treille et coll., 2014a ; Treille et coll., 2017 ; Treille et coll., 2014b ; Treille et coll., 2018, van Wassenhove et coll., 2005). Par conséquent, ce complexe est généralement considéré comme un marqueur fiable de l’intégration audiovisuelle. Dans une étude menée par Pascale Tremblay, la directrice du laboratoire, nous avons examiné le processus d’intégration audiovisuelle chez des personnes âgées en mesurant le complexe P1-N1-P2. Nos résultats démontrent que la composante P1, qui marque un traitement auditif de base, n’est pas affectée par l’âge. Pour les composantes N1 et P2, malgré certains changements, ce complexe, et le travail d’intégration qu’il reflète, demeurent tout à fait fonctionnel avec l’âge. Toutefois, la capacité à lire sur les lèvres diminue grandement (Tremblay et coll., 2021). D’autres équipes de recherche ont observé que l’effet McGurk fonctionnait davantage chez les personnes plus âgées que chez les plus jeunes, ce qui suggère que l’utilisation des informations auditives et visuelles pour percevoir la parole évolue avec l’âge (Hirst et coll., 2018; McGurk & MacDonald, 1976; Sekiyama et coll., 2014).

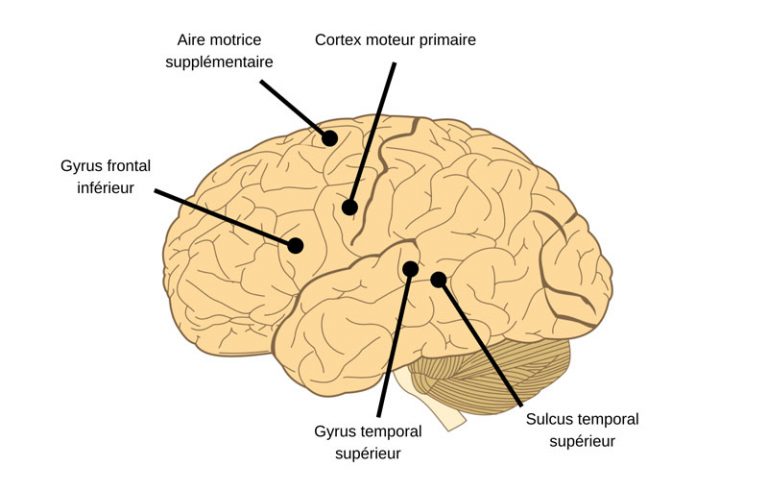

Comme l’EEG ne fournit pas d’information précise sur les régions du cerveau impliquées dans l’intégration audiovisuelle, plusieurs équipes ont plutôt utilisé l’imagerie par résonance magnétique (IRM) et la neurostimulation pour identifier les régions du cerveau impliquées dans ce processus. Pour une méta-analyse sur les régions du cerveau impliquées dans l’intégration de l’information audiovisuelle lors de la perception de la parole, voir Erickson et coll. (2014a). Parmi ces régions, on retrouverait les régions temporales postérieures bilatérales, incluant le sulcus temporal supérieur et le gyrus temporal supérieur (Beauchamp et coll., 2010; Nath & Beauchamp, 2012; Erickson et coll., 2014a-b; voir figure 2). Par exemple, lorsque le fonctionnement du sulcus temporal supérieur gauche est inhibé chez des participants et participantes à l’aide de la stimulation magnétique transcrânienne (TMS), la probabilité de percevoir l’illusion serait réduite, ce qui suggère que cette région joue un rôle important dans l’intégration audiovisuelle (Beauchamp et coll., 2010). De plus, l’activité du sulcus temporal supérieur gauche, telle que mesurée par l’IRM, serait associée à la sensibilité des individus à l’effet McGurk : les personnes présentant une activité plus faible dans cette région seraient moins susceptibles de percevoir l’illusion (Nath & Beauchamp, 2012), donc d’intégrer l’information auditive et visuelle.

Figure 2. Localisation de certaines régions cérébrales pouvant jouer un rôle dans l’intégration audiovisuelle (Human-brain), adapté de James.md.mz, sous licence CC BY-SA 3.0.

D’autres régions joueraient un rôle dans l’intégration audiovisuelle, tel le gyrus frontal inférieur (Erickson et coll., 2014a; voir figure 2). Une équipe de recherche a en effet observé chez des participants et participantes une plus grande activité dans le gyrus frontal inférieur bilatéral lorsque l’information auditive et visuelle était discordante (p. ex. audio /ba/ combiné au visuel /ga/), en comparaison à lorsque l’information auditive et visuelle était concordante (p. ex. audio /ba/ combiné au visuel /ba/; Murakami et coll., 2018). Cette région pourrait donc être importante pour résoudre les incohérences entre les informations auditives et visuelles lors de la perception de la parole. Cette hypothèse est aussi appuyée par le fait qu’une plus grande activité dans le gyrus frontal inférieur gauche serait associée à une moins grande probabilité que l’illusion se produise (Murakami et coll., 2018).

Les aires motrices -celles qui contrôlent nos mouvements- telles le cortex moteur primaire ou l’aire motrice supplémentaire, seraient également impliquées dans l’intégration audiovisuelle lors de la perception de la parole (Erickson et coll., 2014a, Skipper et coll., 2007; voir figure 2). Par exemple, une étude a observé que la TMS appliquée sur la région du cortex moteur qui contrôle les lèvres, diminuait la probabilité que l’illusion se produise lorsque l’information auditive et visuelle était discordante (Murakami et coll., 2018). Cette étude, et d’autres similaires (p. ex. Sato et al., 2009; Tremblay & Small, 2011 – voir aussi le chapitre de livre de McGettigan & Tremblay, 2017), suggèrent que des régions du cerveau servant à produire la parole sont aussi utilisées pour percevoir la parole, bien que leur rôle spécifique dans l’intégration audiovisuelle demeure inconnu.

Bref, plusieurs régions du cerveau, dans les lobes temporaux et frontaux, contribueraient à intégrer l’information auditive et visuelle lors de la perception de la parole et pourraient contribuer à produire l’effet McGurk !

Voici d’autres illusions à essayer, reflétant également l’effet McGurk :

Dans ces deux vidéos, c’est le même enregistrement audio qui est présenté, contenant le son /ba/. Toutefois, l’articulation présentée diffère entre les deux vidéos. C’est pourquoi vous pourriez avoir entendu le son /va/ dans la première vidéo et le son /da/ dans la deuxième, malgré que l’information auditive soit en réalité identique.

Lecture suggérée:

- L’effet «cocktail party» expliqué

- La perception d’un mot en étapes

- La perception de la parole : une faculté complexe

- Différences entre la parole, le langage et la communication

Références :

Beauchamp, M. S., Nath, A. R., & Pasalar, S. (2010). fMRI-guided transcranial magnetic stimulation reveals that the superior temporal sulcus is a cortical locus of the McGurk effect. The Journal of Neuroscience, 30(7), 2414–2417. DOI: 10.1523/JNEUROSCI.4865-09.2010

Besle, J., Fort, A., Delpuech, C., & Giard, M.-H. (2004). Bimodal speech: Early suppressive visual effects in human auditory cortex. European Journal of Neuroscience, 20(8), 2225–2234. DOI: 10.1111/j.1460-9568.2004.03670.x

Erickson, L. C., Heeg, E., Rauschecker, J. P., & Turkeltaub, P. E. (2014a). An ALE meta‐analysis on the audiovisual integration of speech signals. Human Brain Mapping, 35(11), 5587–5605. DOI: 10.1002/hbm.22572

Erickson, L. C., Zielinski, B. A., Zielinski, J. E. V., Liu, G., Turkeltaub, P. E., Leaver, A. M., & Rauschecker, J. P. (2014b). Distinct cortical locations for integration of audiovisual speech and the McGurk effect. Frontiers in Psychology, 5, Article 534. DOI: 10.3389/fpsyg.2014.00534

Klucharev, V., Möttönen, R., & Sams, M. (2003). Electrophysiological indicators of phonetic and non-phonetic multisensory interactions during audiovisual speech perception. Cognitive Brain Research, 18(1), 65–75. 10.1016/j.cogbrainres.2003.09.004

Luck, S. J. (2014). An introduction to the event-related potential technique: MIT press.

McGurk, H., and MacDonald, J. (1976). Hearing lips and seeing voices. Nature 264, 746–748. DOI: 10.1038/264746a0

Murakami, T., Abe, M., Wiratman, W., Fujiwara, J., Okamoto, M., Mizuochi-Endo, T., Iwabuchi, T., Makuuchi, M., Yamashita, A., Tiksnadi, A., Chang, F.-Y., Kubo, H., Matsuda, N., Kobayashi, S., Eifuku, S., & Ugawa, Y. (2018). The motor network reduces multisensory illusory perception. The Journal of Neuroscience, 38(45), 9679–9688. DOI: 10.1523/JNEUROSCI.3650-17.2018

Nath, A. R., & Beauchamp, M. S. (2012). A neural basis for interindividual differences in the McGurk effect, a multisensory speech illusion. NeuroImage, 59(1), 781–787. DOI: 10.1016/j.neuroimage.2011.07.024

Sekiyama, K., Soshi, T., & Sakamoto, S. (2014). Enhanced audiovisual integration with aging in speech perception: A heightened McGurk effect in older adults. Frontiers in Psychology, 5, Article 323. DOI: 10.3389/fpsyg.2014.00323

Skipper, J. I., van Wassenhove, V., Nusbaum, H. C., & Small, S. L. (2007). Hearing lips and seeing voices: How cortical areas supporting speech production mediate audiovisual speech perception. Cerebral Cortex, 17(10), 2387–2399. DOI: 10.1093/cercor/bhl147

Treille, A., Cordeboeuf, C., Vilain, C., & Sato, M. (2014a). Haptic and visual information speed up the neural processing of auditory speech in live dyadic interactions. Neuropsychologia, 57, 71–77. DOI:10.1016/j.neuropsychologia.2014.02.004

Treille, A., Vilain, C., Kandel, S., & Sato, M. (2017). Electrophysiological evidence for a self-processing advantage during audiovisual speech integration. Experimental Brain Research, 235(9), 2867–2876. DOI: 10.1007/s00221-017-5018-0

Treille, A., Vilain, C., & Sato, M. (2014b). The sound of your lips: Electrophysiological cross-modal interactions during hand-to-face and face-to-face speech perception. Frontiers in Psychology, 5, Article 420. DOI: 10.3389/fpsyg.2014.00420

Treille, A., Vilain, C., Schwartz, J.-L., Hueber, T., & Sato, M. (2018). Electrophysiological evidence for Audio-visuo-lingual speech integration. Neuropsychologia, 109, 126–133. DOI: 10.1016/j.neuropsychologia.2017.12.024

van Wassenhove, V., Grant, K. W., & Poeppel, D. (2005). Visual speech speeds up the neural processing of auditory speech. PNAS Proceedings of the National Academy of Sciences of the United States of America, 102(4), 1181–1186. DOI: 10.1073/pnas.0408949102

Autre lecture intéressante :

Tiippana, K. (2014) What is the McGurk effect? Frontiers in Psychology, 5, DOI:10.3389/fpsyg.2014.00725