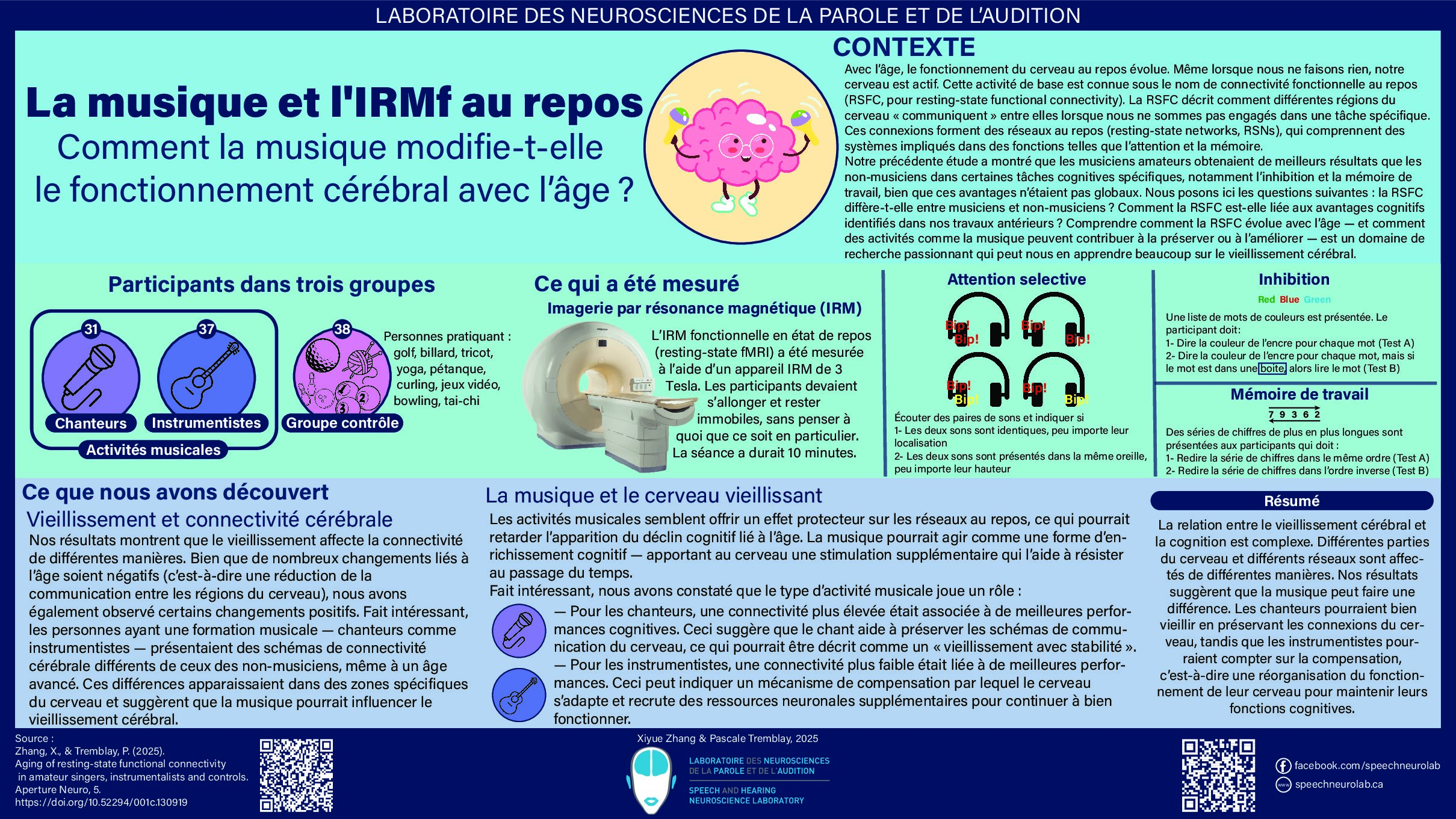

Ce texte est le quatrième de la série sur le traitement des sons de la parole. Dans les publications précédentes, nous avons présenté les premières étapes du traitement de la parole, de l’oreille jusqu’au cortex auditif (figure 1). Lorsque le traitement auditif central est complété avec succès, des niveaux de traitement supplémentaires, linguistiques, sont nécessaires pour le traitement des sons du langage afin de les identifier et de les interpréter, et de comprendre le sens du message. Le signal de parole poursuit donc son chemin à l’intérieur du cerveau !

Figure 1. Résumé des principaux systèmes impliqués dans le traitement des sons de la parole.

La prochaine grande étape est la perception de la parole, au cours de laquelle notre cerveau établit une correspondance entre le signal acoustique et des représentations mentales (p. ex. des sons, des syllabes, des mots). Deux grandes questions se posent dans l’étude de ce processus :

- Qu’est-ce que le cerveau perçoit? ou quelle est la nature des unités linguistiques fondamentales que notre cerveau utilise durant la perception de la parole (des sons, des syllabes, des morphèmes, des mots)?

- Comment le cerveau perçoit? ou de quelle façon parvient-il à segmenter et identifier ces unités?

PARTIE A : Qu’est-ce que le cerveau perçoit?

La perception de la parole (et la perception en général) est dite catégorielle, c’est-à-dire que les unités linguistiques sont divisées en catégories distinctes dans notre cerveau. Ceci signifie que nous percevons plus facilement des différences entre des unités faisant partie de catégories différentes comparativement à des différences entre des items provenant de la même catégorie.

Ce phénomène est également observable dans le système visuel. Par exemple, l’arc-en-ciel présente un continuum de toutes les couleurs visibles à l’œil humain; pourtant, nous avons plutôt l’impression de voir des bandes de couleurs juxtaposées (p. ex. rouge, orange, jaune, vert, bleu, indigo, violet).

Notre cerveau utilise donc des catégories ayant chacune des propriétés distinctes ; mais quelle est la nature fondamentale de ces catégories? La plus petite unité de représentation linguistique est le phonème. Le phonème est un son du langage (une voyelle ou une consonne) possédant des propriétés uniques. Ces propriétés, aussi appelées traits phonologiques ou traits distinctifs, reflètent la façon dont nous positionnons les organes et les muscles de la bouche et des cordes vocales. Cette capacité ressemble à celle d’un instrument de musique, qui peut produire différents sons en changeant la configuration des doigts. Par exemple, les mots cas (/ka/) et ta (/ta/) se distinguent par les phonèmes /k/ ou /t/, qui eux se distinguent par le lieu d’articulation, c’est-à-dire le lieu où la langue est placée dans la bouche. Vous pouvez vous-même tenter l’expérience en prononçant en boucle les mots /ta/ et /ka/ et en portant attention à la position de votre langue. À noter que le système de phonèmes (ou sons distinctifs) diffère d’une langue à l’autre. Notre perception des phonèmes est meilleure pour les sons des langues que nous connaissons!

Des études suggèrent que la perception de la parole ne repose pas uniquement sur ces représentations dites auditives (phonologiques). En effet, pour soutenir le processus de perception de la parole, notre cerveau fait appel à d’autres représentations linguistiques (p. ex. les morphèmes, les mots), les représentations visuelles (le mouvement des lèvres) et les représentations articulatoires (la position des muscles et articulateurs dans la bouche nous permettant de produire des sons de parole). Par exemple, l’effet McGurk, que nous avons abordé dans une autre publication, révèle que notre cerveau utilise la lecture labiale (le mouvement des lèvres) pour percevoir la parole, bien que nous n’en soyons souvent pas conscients (cliquez ici pour tenter l’expérience) : en effet, il est plus facile de percevoir la parole lorsqu’elle est à la fois auditive et visuelle.

PARTIE B : Comment le cerveau perçoit?

On peut distinguer deux processus importants durant la perception de la parole : le découpage du signal en unités plus petites, appelé segmentation, ainsi que l’identification de ces unités.

- La segmentation de la parole

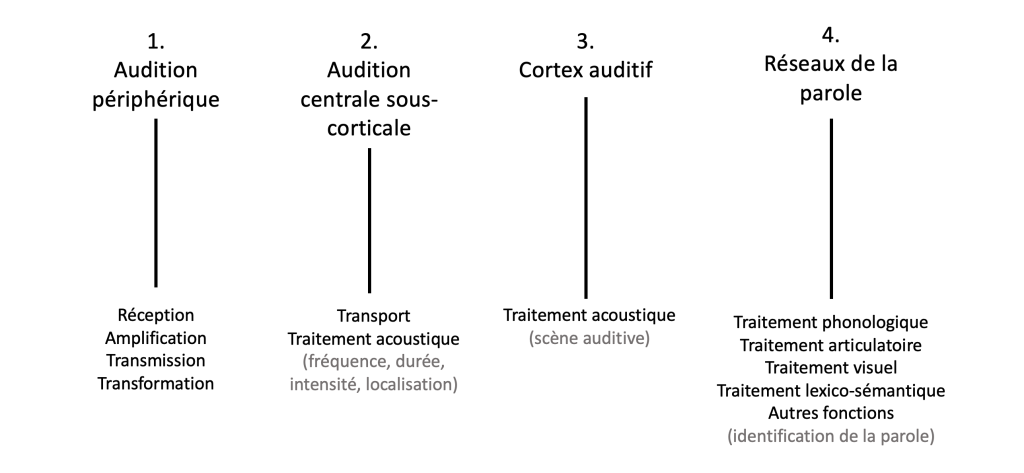

Contrairement à l’écriture, les mots à l’oral sont produits dans un flot continu (voir figure 2). Ainsi, bien que nous ayons l’impression d’entendre des mots séparés, cette perception est en réalité le fruit d’un travail laborieux du cerveau, qui doit définir les limites pertinentes entre des unités de parole. Nous pouvons d’ailleurs constater le défi que représente ce découpage du signal lors de l’apprentissage d’une nouvelle langue, pour laquelle le cerveau n’a pas la même expertise en matière de segmentation, ou lorsqu’on entend une langue inconnue, laquelle nous apparaît rapide, car nous n’arrivons pas à en extraire les mots.

Figure 2.Cet oscillogramme représente la phrase « le chaton s’amuse avec une balle de laine ». Les lettres sont placées approximativement au-dessus de leur position réelle dans le signal acoustique. Bien que ce signal semble découpé en sections, ces segments ne correspondent pas du tout aux mots.

Des études ont suggéré que dès les premiers mois de la vie, les enfants peuvent distinguer des sons et des séquences de sons (p. ex. syllabes, mots) en utilisant une variété d’indices acoustiques, dont l’intonation, les accents, et la fréquence à laquelle des séquences de sons sont produits dans l’environnement. Toute cette information est utilisée par les bébés et les jeunes enfants pour acquérir des nouveaux mots.

2. L’identification de la parole

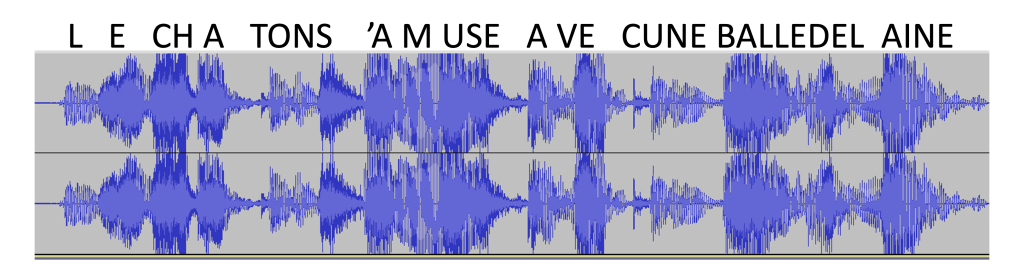

En raison de la grande efficacité de notre cerveau à comprendre le langage, on pourrait penser que le processus d’identification des mots est simple. Pourtant, observez la complexité des signaux acoustiques ci-dessous (figure 3):

Figure 3. La section du haut (un oscillogramme) permet d’observer les changements d’intensité (plus fort ou moins fort) dans le temps, alors que la section du bas (un spectrogramme) illustre l’intensité des sons (plus le trait est noir plus l’intensité est forte) et la composition spectrale (plus grave vers le bas et plus aigu vers le haut) en fonction du temps. D’autres exemples de ces graphiques sont détaillés dans l’article suivant : https://speechneurolab.ca/science-poupees-russes-la-suite/.

On constate que des mots très différents tels que « train » et « proue » sont très semblables sur le plan acoustique (intensité, durée, fréquence). Le découpage et l’identification de chaque portion du signal représentent donc un défi de taille ! Cette analyse doit également prendre en compte la grande variabilité du signal acoustique, c’est-à-dire qu’un même son peut être produit de multiples façons en fonction des caractéristiques du locuteur (la personne qui parle) (p. ex. la hauteur de la voix, l’accent, l’intonation, l’émotion), du contexte (p.ex. les sons qui précèdent et qui suivent, le type de discours, le mode de communication) et de tout type d’événement qui pourrait interférer avec le signal acoustique, tels la présence de bruits ou un simple moment d’inattention. Tous ces éléments doivent être pris en compte afin que le cerveau effectue une bonne interprétation du signal de parole.

D’ailleurs, la reconnaissance vocale par ordinateur fut un défi particulièrement difficile à relever dans les dernières décennies, en raison d’une sous-estimation de la grande variabilité du signal acoustique. En effet, bien que l’on ait aujourd’hui beaucoup de connaissances sur les propriétés des phonèmes, qui ont été intégrées dans les systèmes de reconnaissance, ces représentations « numériques » des sons furent clairement insuffisantes pour identifier précisément les sons et les mots dans différents contextes d’enregistrement.

Alors, comment le cerveau y arrive-t-il? Un élément clé de réponse est que le cerveau émet des prédictions sur ce qui a été entendu, non seulement à partir d’un grand nombre d’indices sensoriels et contextuels, mais également à partir de toutes ses connaissances antérieures enregistrées en mémoire. La perception de la parole est donc le fruit de l’analyse efficace d’un ensemble d’indices, mais aussi de l’exposition répétée au langage, à travers une grande variété de contextes et de locuteurs. Le cerveau développe ainsi une expertise, formant en mémoire des représentations abstraites pertinentes au traitement des sons de la parole auxquels il a été exposé. Le cerveau peut ainsi, en faisant appel à une multitude de réseaux et de mécanismes, identifier la parole même lorsque l’information auditive est incomplète. Le phénomène de restauration phonémiqueillustre bien cette habileté : lorsqu’une partie du signal acoustique est ambiguë ou « embrouillée » (p.ex. durant l’écoute de parole en présence de bruits), notre cerveau est capable de « restaurer » mentalement l’information manquante. Vous pouvez vous-même tester cette illusion perceptuelle dans la vidéo ci-dessous :

Le processus de reconnaissance vocale informatique s’est d’ailleurs grandement amélioré avec l’apparition de l’intelligence artificielle, par laquelle on « expose » l’ordinateur à une grande variété de signaux de parole, ce qui améliore sa capacité à prédire ce qui a été produit.

PARTIE C : Les réseaux impliqués dans la perception de la parole

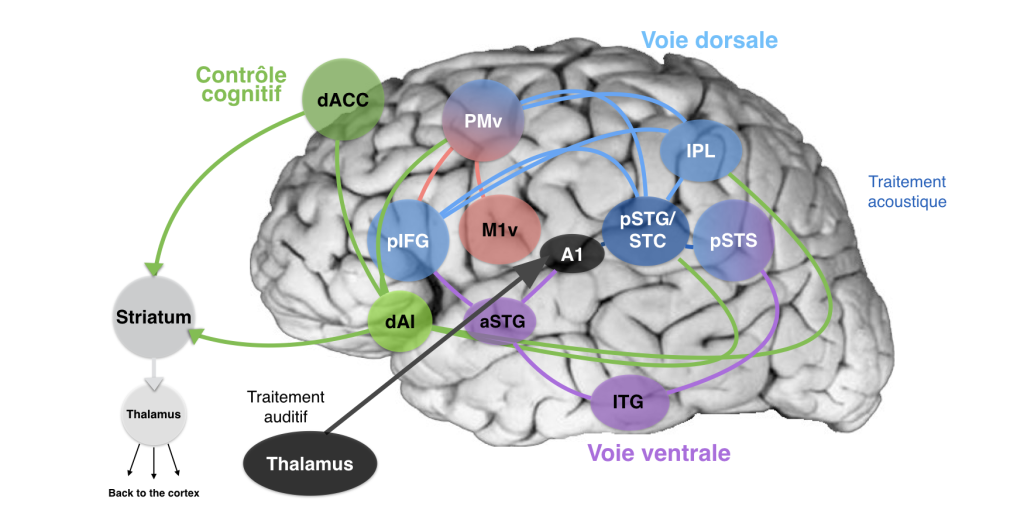

Les données recueillies grâce aux techniques de neuroimagerie et de neurostimulation au cours des quarante dernières années ont contribué à une meilleure compréhension des mécanismes neurobiologiques qui sous-tendent la perception de la parole. Comme mentionné précédemment, l’interprétation du signal de parole est difficile et nécessite la participation d’une multitude de systèmes différents qui interagissent (figure 4 ci-dessous).

Le cortex temporal supérieur (incluant le gyrus temporal supérieur et le sulcus temporal supérieur) est classiquement identifié comme étant une région au cœur de la perception de la parole. C’est notamment dans la région postérieure de ce cortex que se trouveraient les représentations abstraites auditives (dites « phonologiques ») de la parole.

Comme discuté ci-dessus, plusieurs niveaux de représentations contribuent au traitement de la parole. En effet, les régions associées au traitement visuel (lobe occipital), multimodal (lobule pariétal inférieur ou IPL) et articulatoire (cortex prémoteur ou PMv, cortex moteur primaire ou M1) contribuent aussi à l’identification des sons du langage à travers la voie dorsale de la parole (Figure 4).

Les régions associées au traitement sémantique (l’accès à la signification, au sens des mots, des discours, des concepts) participent également à la perception de la parole (pôle temporal, gyrus temporal moyen et gyrus temporal inférieur ou ITG) à travers la voie ventrale. Les représentations sémantiques permettent à notre cerveau de prédire les mots qui ont été dits en fonction du contexte et de notre lexique mental. Le gyrus inférieur frontal (IFG) est une autre région-clé du traitement de la parole et du langage, étant notamment impliquée dans le traitement phonologique (partie postérieure) et l’accès lexical (partie antérieure).

Finalement, des régions impliquées dans les fonctions cognitives et exécutives (p. ex. la mémoire verbale à court terme, pour mémoriser les sons entendus, l’attention ; en vert sur la figure 4) sont sollicitées durant le traitement de la parole, incluant le gyrus cingulaire, le cortex insulaire, le striatum, et le thalamus.

Figure 4. Cette figure illustre les nombreux réseaux qui sont impliqués dans la perception de la parole, ainsi que leurs interactions complexes. Lorsque la parole est entendue, un traitement acoustique préliminaire s’effectue dans le thalamus et dans le cortex auditif en noir (voir articles précédents : Le système auditif central sous-cortical ; Le cortex auditif). La voie dorsale (en bleu) inclut un ensemble de régions qui contiennent des représentations abstraites de la parole qui participent à son identification. Dans la voie ventrale (en mauve), un traitement sémantique est effectué; l’accès au sens des mots et aux connaissances antérieures des mots permet également de prédire la parole. © Pascale Tremblay

En résumé, la perception de la parole implique la participation de nombreux réseaux et de nombreuses représentations abstraites qui permettent de prédire la parole, bien que le signal acoustique soit fortement variable et souvent incomplet.

Références :

Jusczyk PW, Houston DM, Newsome M. The beginnings of word segmentation in english-learning infants. Cogn Psychol. 1999 Nov-Dec;39(3-4):159-207. doi: 10.1006/cogp.1999.0716. PMID: 10631011.

Schomers, M. R., & Pulvermüller, F. (2016). Is the Sensorimotor Cortex Relevant for Speech Perception and Understanding? An Integrative Review. Front Hum Neurosci, 10, 435. doi:10.3389/fnhum.2016.00435

Autres textes de la série :

- Le système auditif périphérique (texte 1 de 4).

- Le système auditif central sous-cortical (texte 2 de 4).

- Le cortex auditif (texte 3 de 4).