Imaginez que vous participez à un événement social, par exemple une soirée cocktail. Les conversations affluent autour de vous pendant que vous parlez avec un ami, puis tout à coup vous entendez votre nom prononcé à l’autre bout de la salle. Comment pouvez-vous écouter et comprendre votre ami tout en entendant une conversation dans la pièce ? Il s’agit d’un exemple d’un phénomène appelé « l’effet cocktail party ». Comprendre la parole en présence de conversations est un défi pour tous et toutes, mais surtout pour les enfants et les personnes âgées. Dans ce billet, nous discutons de ce qu’est l’effet cocktail party et des mécanismes cognitifs impliqués.

Lors d’un événement social, de nombreuses conversations et bruits différents sont produits simultanément. Cette quantité de bruit et d’information pourrait nous submerger. Cette hypothèse est partiellement correcte. Les humains ont en effet une capacité limitée à traiter l’information. Dans l’article fondateur « Some Experiments on the Recognition of Speech, with One and with Two Ears », Colin E. Cherry (1953) a décrit pour la première fois l’effet cocktail. Cherry a découvert que lorsque nous entendons deux messages simultanément, nous sommes incapables de comprendre la signification de l’un ou l’autre message à moins que leur contenu ne soit distinct.

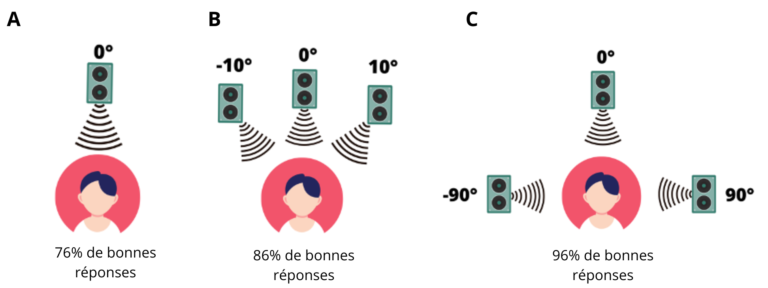

En poursuivant les travaux de Cherry, les équipes de recherche ont découvert que lorsque les voix sont séparées spatialement (par exemple, trois haut-parleurs situés à 10 degrés, 0 degré et -10 degrés devant un auditeur, figure 1B), il est plus facile de comprendre un message simultané que lorsque toutes les voix proviennent d’une seule direction (Figure 1A) (Spieth et al., 1954, cité dans Aarons, 1992). Une plus grande différence de séparation spatiale entre les voix (par exemple, 90 degrés, 0 degré et -90 degrés) permet aux personnes de répéter plus précisément le message suivi (Figure 1C). Une explication possible est que la séparation nous permet de sélectionner plus facilement un flux sonore auquel nous intéresser.

Maurizio Corbetta et Gorden L. Shulman (2002) de l’Université de Washington ont développé un modèle à double processus pour expliquer comment le centre de l’attention est déterminé. Le premier processus de ce modèle est l’attention dirigée vers un objectif (attention descendante ou « top-down » en anglais). Par exemple, votre objectif est d’entendre votre ami lors d’une soirée bondée, ainsi plus d’attention sera consacrée à votre conversation avec votre ami. Ce processus est soutenu par les zones cérébrales du réseau fronto-pariétal dorsal. Lorsque nous concentrons notre attention sur un objectif (par exemple, une conversation), ce réseau peut filtrer les informations non pertinentes et faire en sorte que ces informations ne soient pas surveillées. Il est important de noter que l’information ainsi « filtrée » est tout de même entendue. Lee M. Miller du Département de neurobiologie de l’Université de Californie (2016) suggère que nous accordons différents niveaux d’attention à plusieurs signaux. Par exemple, si notre objectif est d’avoir une conversation, notre interlocuteur recevra une grande attention et le bruit constant d’une machine à laver sera filtré. En accordant de faibles niveaux d’attention au bruit de fond, nous sommes en mesure de mieux nous concentrer sur la tâche (par exemple, la conversation). Malgré tout, dans ce bruit de fond, des signaux peuvent détourner notre attention et nous faire perdre notre centre d’attention (« focus »).

Le deuxième processus du modèle d’attention sélective de Corbetta et Shulman est l’attention involontaire (attention dite « ascendante » ou « bottom-up » en anglais). Par exemple, imaginez encore que vous parlez à votre ami lors d’une fête puis que quelqu’un crie votre nom. Votre attention sera dirigée vers ce signal. Ce processus est soutenu par les zones cérébrales du réseau frontopariétal ventral droit. Corbetta et Shulman suggèrent que ce réseau agit comme un disjoncteur dirigeant notre attention vers quelque chose qui est pertinent sur le plan comportemental en dehors de ce sur quoi nous concentrons notre traitement. Lorsque ces zones détectent un signal nouveau, elles réorientent notre attention. Lorsque ce réseau détecte un stimulus peu fréquent ou hors du commun qui nous concerne, l’activation dans ce réseau augmente. Par exemple, puisque votre nom vous concerne, les zones de ce réseau pourraient s’activer et déclencher un changement d’attention.

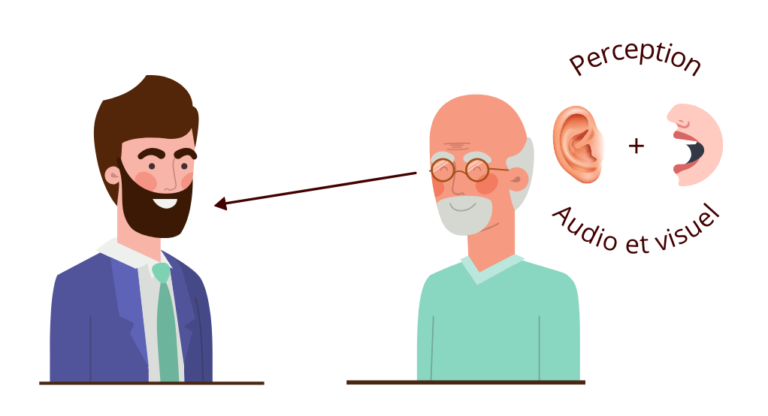

Lorsque nous conversons avec un ami lors d’un événement social, notre système attentionnel n’est pas le seul système en jeu. Non seulement nous devons concentrer notre attention, mais nous devons également percevoir et comprendre ce que dit notre ami. Nous allons maintenant discuter de certains des processus qui nous permettent de percevoir et de comprendre une conversation dans un environnement bruyant.

Information visuelle

Dans un environnement complexe et bruyant (par exemple, un cocktail) avec de nombreux signaux différents, notre système visuel est essentiel pour traiter une conversation. Le traitement visuel de la parole fait référence à la capacité à traiter les mouvements de la bouche, de la mâchoire, des lèvres et (dans une certaine mesure) de la langue de notre interlocuteur. Ces informations aident à comprendre la parole, en particulier dans des situations difficiles.

Un exemple révélateur de l’importance des informations visuelles est connu sous le nom d’effet McGurk-MacDonald (1976), souvent appelé effet McGurk. L’effet McGurk a été développé par Harry McGurk et John MacDonald en 1976 à l’Université de Surrey. Cet effet démontre que les informations visuelles peuvent modifier la façon dont nous percevons les sons. Par exemple, si on vous présente le son « ba », mais le stimulus visuel « ga », vous entendrez probablement le son « da », c’est-à-dire un son qui n’a été ni entendu ni vu, mais qui représente une combinaison des stimuli auditifs et visuels. Cet effet est causé par l’intégration entre les processus auditifs et visuels . Pour un aperçu plus détaillé de l’effet McGurk, consultez notre article de blogue .

Si vous avez du mal à comprendre ce que dit votre ami à cause du bruit de fond, votre connaissance de la façon dont votre ami articule vous aidera à comprendre ce qu’il raconte ; inversement, une conversation avec une personne moins familière présentera un défi plus grand. En effet, nous parlons tous et toutes de manière unique ; ces différences (par exemple, accent, intonation, débit, manière de produire certains sons, tics langagiers) rendent la compréhension de la parole une tâche ardue. Notre cerveau doit trouver un moyen de traiter ces différences. Shannon Heald, Serena Klos et Howard Nusbaum (2016) de l’Université de Chicago suggèrent que nous pouvons prendre en compte les expériences antérieures pour faciliter notre compréhension. Par exemple, votre ami a un accent régional caractérisé par la présence de « r » roulés dans certains mots; vous pouvez utiliser vos connaissances pour vous aider à traiter son discours dans un environnement bruyant. Ainsi, lors d’un cocktail, il sera plus facile de discuter avec une personne connue qu’une personne inconnue.

Interpréter la parole dans son contexte

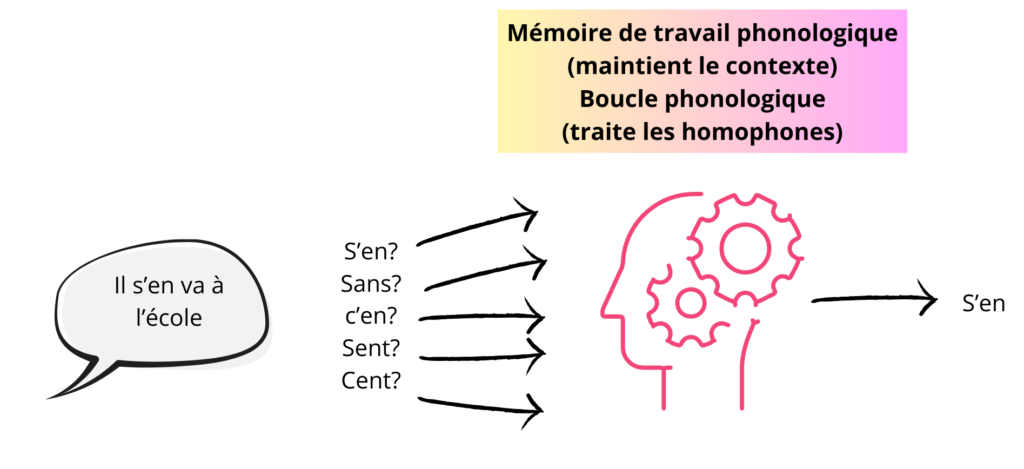

Un autre facteur à considérer est la manière dont nous prenons en compte le contexte du mot lors du traitement langagier. Par exemple, prenons les mots couramment utilisés « s’en », « sans », « cent », « sent » et « c’en ». Ces mots sonnent tous et sont articulés de la même manière, cependant, selon le contexte, vous pourrez les différencier presque automatiquement (Figure 2).

La mémoire de travail phonologique est utilisée pour conserver les sons de la parole ou les mots en mémoire lors de l’écoute d’une phrase (Perrachione, Ghosh, Ostrovskaya, Gabrieli & Kovelman, 2017). Cela nous permet de conserver le contexte de la phrase, ce qui aide à la compréhension. Alan D Baddeley et Graham J. Hitch de l’Université de York ont suggéré qu’il existe deux processus qui nous permettent de différencier les homophones ; ces processus forment ce que Baddeley et Hitch appellent la boucle phonologique. Le premier processus est essentiel au maintien des informations. Ce processus nous permet de répéter un ou plusieurs mots dans notre tête et de les décomposer pour en comprendre chaque syllabe et chaque phonème. Le deuxième processus est utilisé pour porter des jugements sur les homophones (par exemple, « s’en », « sent », « cent », « sans » ou « c’en »). Ces deux processus nous permettent de déterminer quel homophone est correct dans un contexte précis (Figure 2).

Probabilités de transition

Lorsque vous parlez à un ami lors d’un événement social, le bruit de fond dégrade le flux de parole que vous tentez de traiter. Cette dégradation peut entraîner des difficultés de perception et de compréhension de parole. Alors, comment pouvons-nous segmenter ce flux pour comprendre ce que dit notre ami ? Notre cerveau traite ce que l’on appelle les « probabilités de transition » pour déterminer quand un mot se termine et quand un autre commence. Brièvement, il s’agit de calculer la probabilité qu’une syllabe suive ou précède une autre syllabe. Chaque langage du monde possède ainsi ses propres statistiques. Une faible probabilité de transition indique généralement la fin d’un mot ; cette information nous aide à décoder ce qui est dit.

Par exemple, la probabilité que la syllabe « q » soit suivie d’un « u » est très élevée, on peut donc supposer qu’elles font partie du même mot. Alors que la probabilité que la syllabe « d » soit suivie de la syllabe « f » dans le même mot est très faible, on peut donc supposer qu’il s’agit du début d’un nouveau mot (Dal Ben, Souza & Hay, 2021). Des résultats de notre laboratoire suggèrent qu’une région du cerveau appelée le planum temporal est impliquée dans ce traitement statistique du langage (Tremblay, Baroni et Hasson, 2012). L’utilisation des probabilités de transition peut nous aider à décomposer la parole et à restaurer les informations manquantes. Nous avions même développé un outil au laboratoire pour étudier les statistiques d’utilisation des sons du langage (phonèmes, morphèmes, syllabes et mots). Cet outil se nomme SyllabO+. Cliquez ici pour en savoir plus.

Conclusion

En somme, l’effet cocktail se produit grâce à de nombreux processus différents agissant simultanément. De plus en plus de travaux sont réalisés pour explorer ces processus ainsi que les facteurs qui peuvent les affecter, comme l’âge, l’audition et la vision, le bagage linguistique et bien d’autres. Dans notre laboratoire, nous étudions comment l’âge et l’expérience musicale affectent la perception de la parole dans le bruit et les méthodes permettant de réduire cet effet, comme la stimulation cérébrale.

Références :

Arons, B. (1992). A review of the cocktail party effect. Journal of the American Voice I/O Society, 12(7), 35-50.

Cherry, E. C. (1953). Some experiments on the recognition of speech, with one and with two ears. Journal of the Acoustical Society of America, 25, 975-979.

Corbetta, M., & Shulman, G. L. (2002). Control of goal-directed and stimulus-driven attention in the brain. Nature reviews neuroscience, 3(3), 201-215.

Dal Ben, R., Souza, D. D. H., & Hay, J. F. (2021). When statistics collide: The use of transitional and phonotactic probability cues to word boundaries. Memory & Cognition, 1-11.

Heald, S., Klos, S., & Nusbaum, H. (2016). Understanding speech in the context of variability. In Neurobiology of language (pp. 195-208). Academic Press.

McGurk, H., & MacDonald, J. (1976). Hearing lips and seeing voices. Nature, 264(5588), 746-748.

Miller, L. M. (2016). Neural mechanisms of attention to speech. In Neurobiology of language (pp. 503-514). Academic Press.

Perrachione, T. K., Ghosh, S. S., Ostrovskaya, I., Gabrieli, J. D., & Kovelman, I. (2017). Phonological working memory for words and nonwords in cerebral cortex. Journal of Speech, Language, and Hearing Research, 60(7), 1959-1979.

Tremblay, P., Baroni, M., & Hasson, U. (2013). Processing of speech and non-speech sounds in the supratemporal plane: Auditory input preference does not predict sensitivity to statistical structure. Neuroimage, 66, 318-332.